Avec l’introduction d’AI Mode dans Google Search aux USA, la recherche d'information sur le web connaît l’une des transformations les plus radicales de son histoire. Exit les ancestraux résultats disposés sous forme de liens bleus : place aux réponses synthétiques, personnalisées et multi-format, générées par des modèles d’intelligence artificielle capables de « raisonner ». Pour les professionnels du SEO, c’est un nouveau territoire aux règles encore floues, mais profondément différentes. Retour sur les enseignements tirés par les experts depuis l’introduction du AI Mode aux USA.

Ce qu'il faut retenir :

- L’AI Mode de Google repose sur une logique de requêtes synthétiques, de raisonnement et de personnalisation avancée, loin des SERPs classiques.

- Le SEO traditionnel ne suffit plus : il faut désormais structurer le contenu pour les LLMs, au niveau des passages, avec une logique d’ingénierie de la pertinence.

- L’apparition ou non dans l’AI Mode dépend de la similarité sémantique avec des requêtes invisibles générées en arrière-plan.

- Les outils SEO actuels sont obsolètes pour suivre ce mode de recherche : une refonte de l’approche et des métriques est indispensable.

Google AI Mode : une autre manière de chercher

Le moteur de recherche de Google n'est plus ce qu'il était. Avec AI Mode, accessible chez de plus en plus d’internautes, Google propose une expérience où la réponse s’affiche avant même de cliquer. L’interface change, mais surtout, la logique qui sous-tend la recherche n’a plus rien à voir avec celle des SERPs traditionnelles. On n’a plus affaire à une simple hiérarchie de résultats. Désormais, l’intelligence artificielle génère un résumé, une comparaison ou un argumentaire, à partir de contenus qu’elle sélectionne, reformule et assemble.

Cette évolution s’appuie sur plusieurs piliers techniques : la personnalisation à grande échelle via les embeddings utilisateur, la recherche dense par vecteurs sémantiques, et surtout, la capacité à générer des chaînes de raisonnement à partir de requêtes implicites, dites « fan-out ». Autrement dit, quand vous posez une question, Google en génère des dizaines d'autres en arrière-plan pour affiner la compréhension de votre intention.

Un SEO dépassé par la technologie

Le problème, c’est que le SEO tel qu’on le connaît, mots-clés, balises, netlinking, ne prépare pas à cette nouvelle réalité. Les outils dominants du marché (TF-IDF, BM25) sont conçus pour la récupération d'information lexicale. Or, AI Mode repose sur des modèles de récupération dense, à base d’embeddings. Cela signifie que les documents sont représentés comme des vecteurs dans un espace sémantique multidimensionnel, et que Google compare leur proximité à des requêtes reformulées, parfois jamais exprimées explicitement.

Ce décalage rend l’optimisation SEO classique inefficace. On ne sait même pas si une page apparaîtra ou non, car elle peut être partiellement intégrée à une réponse, sans clic, sans lien visible. Le passage cité peut être extrait d’un paragraphe profond, voire reformulé, sans que l’auteur en soit averti.

L’ère de l’ingénierie de la pertinence

Face à ce constat, un nouveau métier émerge : celui d’ingénieur de la pertinence (« relevance engineer »). Son rôle : comprendre les modèles d’IA pour concevoir des contenus qui seront utiles aux chaînes de raisonnement des modèles, sur des sous-requêtes implicites et multiples.

Pour cela, il faut :

- Structurer les contenus en blocs sémantiques auto-suffisants (ou passages),

- Exprimer clairement les comparaisons, les avantages/inconvénients, les données factuelles,

- Intégrer des entités bien définies (produits, marques, lieux) pour favoriser la récupération via le graphe de connaissance de Google (Knowledge Graph),

- Multiplier les formats (texte, vidéo, audio, infographies) pour s’adapter aux préférences multimodales du moteur.

En résumé, il ne s’agit plus de « rédiger pour Google », mais de produire des éléments modulaires et interprétables, qui pourront être combinés par des IA pour répondre à des requêtes que vous ne verrez jamais.

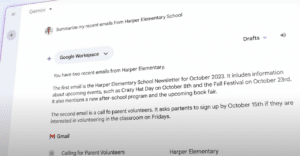

Une personnalisation invisible, mais centrale

L’un des aspects les plus disruptifs d’AI Mode est l’introduction massive de la personnalisation via des user embeddings. Google crée pour chaque utilisateur un vecteur dense qui reflète ses intérêts, ses requêtes passées, sa localisation, ses clics, voire ses données Gmail. Ce vecteur influence toutes les étapes : la reformulation des requêtes, la sélection des documents, et même la forme de la réponse générée (texte, tableau, liste…).

Résultat : deux personnes posant la même question n’obtiendront pas la même réponse. Et cela rend quelque peu obsolètes les outils de suivi de position classiques, qui se « contentent » de simuler un utilisateur générique déconnecté.

De nouveaux outils pour une nouvelle époque

Pour l’instant, très peu d’outils SEO permettent d’opérer dans ce nouvel écosystème. Certains, comme Profound ou Qforia, explorent déjà des approches adaptées : simulation de requêtes fan-out, analyse des citations, visualisation de la pertinence vectorielle, etc.

Mais le marché est en retard. Il manque encore :

- Des éditeurs de contenu sémantique multi-requêtes,

- Des simulateurs de chaînes de raisonnement,

- Des explorateurs d’embedding passage par passage,

- Des mesures de visibilité dans les réponses générées.

Le SEO devient un jeu de stratégie algorithmique dans un environnement probabiliste. Il faut penser en termes de corpus candidats, de passages citables, de chaînes de raisonnement machine, et de réutilisation algorithmique.

Redéfinir les objectifs et les indicateurs

AI Mode transforme aussi les objectifs marketing. Il ne s’agit plus uniquement d’obtenir du trafic, mais d’être présent dans l’univers sémantique du moteur. Cela impose de :

- Mesurer la part de voix dans les réponses générées,

- Analyser les mentions de marques (fréquences, visibilité),

- Évaluer sa présence dans les synthèses, y compris sans clic.

Le SEO s’éloigne donc de la performance directe pour se rapprocher de la stratégie de marque. Il devient un levier de visibilité algorithmique, au service de la crédibilité perçue par les agents conversationnels.