Google a dévoilé Gemma 2, la nouvelle version de sa suite de modèles IA performants et efficaces, destinés aux chercheurs et développeurs. Conçus pour des inférences rapides et économiques, ces nouveaux modèles développés par DeepMind établissent de nouvelles normes en matière de performances.

Ce qu'il faut retenir :

- Gemma 2 surpasse les modèles de taille similaire, notamment le modèle 27B qui rivalise avec des modèles deux fois plus grands.

- Cette suite est conçue pour fonctionner efficacement sur des GPU et TPU courants, réduisant significativement les coûts de déploiement.

- Elle est compatible avec les principaux frameworks AI et disponible sous licence « commercially-friendly ».

- Elle inclut des avancées en matière de sécurité et des outils pour un développement d’IA responsable.

Un nouveau standard de modèle ouvert axé efficacité et performances

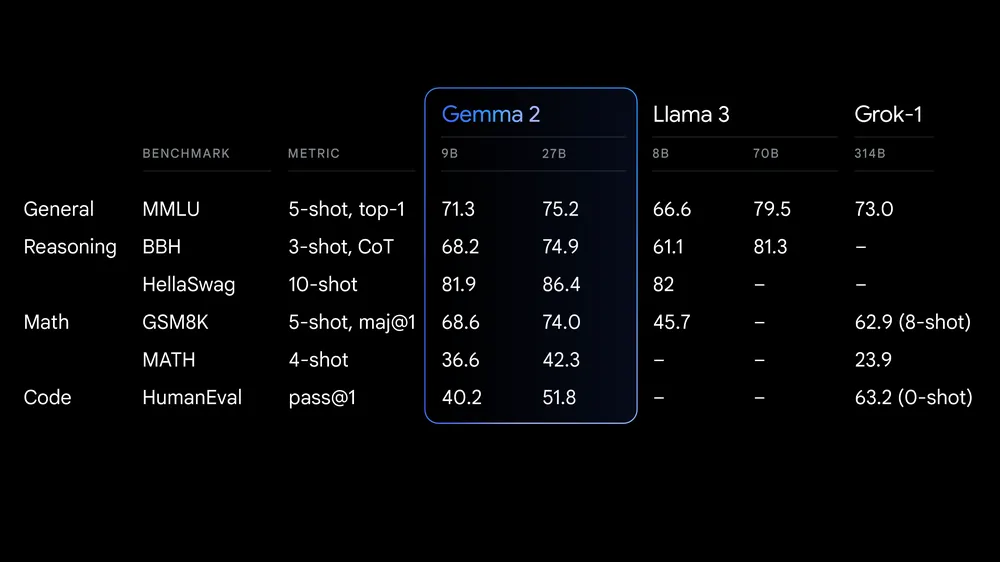

Dans sa publication officielle, Google vante les mérites de Gemma 2 qui offrira des performances exceptionnelles avec ses modèles 9B et 27B. Plus spécifiquement, le modèle 27B (27 milliards de paramètres) propose une alternative compétitive à des modèles équivalents à plus de deux fois sa taille. De son côté, le modèle 9B (9 milliards de paramètres) surpasse des concurrents comme le Llama 3 8B, établissant ainsi de nouveaux standards de performance pour sa catégorie.

Le modèle 27B est conçu pour fonctionner efficacement en inférence en pleine précision sur un seul hôte TPU de Google Cloud, une NVIDIA A100 80GB ou H100 Tensor Core GPU. Cette spécificité pourrait permettre le déploiement d’IA plus accessibles et économiques.

Optimisée pour des vitesses d’inférence élevées, Gemma 2 est conçue pour fonctionner avec une grande variété de matériels, des ordinateurs portables aux infrastructures Cloud. Il est également possible de le tester avec Google AI Studio ou avec Gemma.cpp sur un CPU en local.

Gemma 2 inclura prochainement un modèle de 2.6B de paramètres, afin de combler encore davantage le fossé entre accessibilité légère et performances importantes.

IA Open Source et développement plus responsable

À noter que Gemma 2 est disponible sous licence « commercially-friendly », offrant la possibilité aux développeurs et aux chercheurs de partager et commercialiser leurs innovations. Sa compatibilité est assurée avec des frameworks AI majeurs comme Hugging Face, JAX, PyTorch ou encore TensorFlow via Keras 3.0, vLLM, Gemma.cpp, Llama.cpp et Ollama. Gemma 2 est également optimisée pour NVIDIA TensioRT-LLM. Par ailleurs, à partir du mois prochain, les utilisateurs de Google Cloud pourront déployer et gérer facilement Gemma 2 sur la plateforme de développement Vertex AI.

Google fournit également des ressources aux développeurs pour les aider à construire et déployer des IA de manière responsable, dont un kit d'outils d’IA générative responsable.

Une attention portée à la sécurité

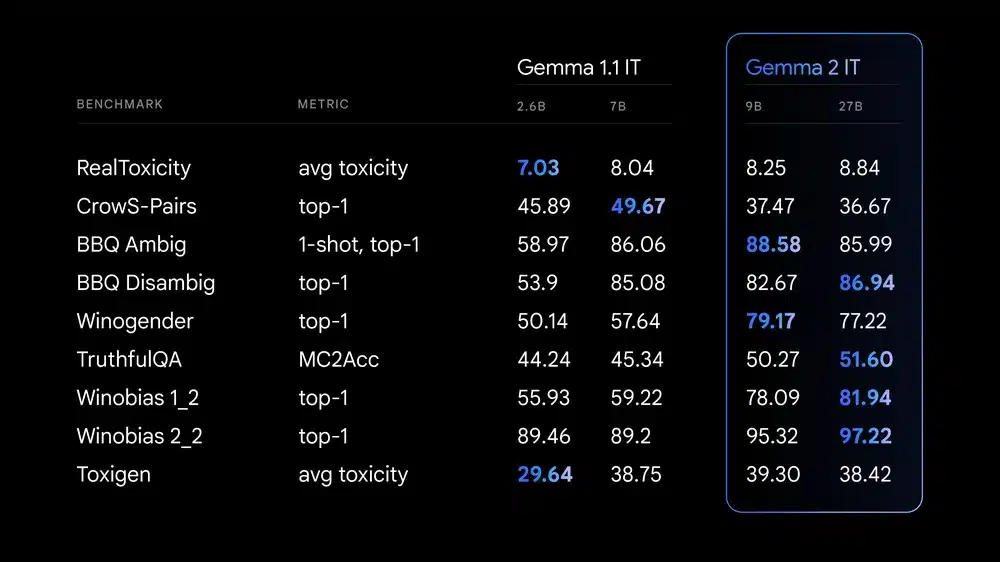

Google a suivi des processus internes rigoureux pour garantir la sécurité lors de l'entraînement de Gemma 2. Des filtres de données de préformation et des tests approfondis ont ainsi été menés pour identifier et atténuer les biais potentiels et les risques. Les résultats sont publiés sur de nombreux benchmarks publics relatifs à la sécurité et aux préjudices représentationnels.

Selon Google, depuis son lancement initial, Gemma a été téléchargée plus de 10 millions de fois, donnant lieu à d'innombrables projets inspirants. Par exemple, le projet Navarasa a utilisé Gemma pour créer un modèle ancré dans la diversité linguistique de l'Inde.

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !