Est-il possible de vouloir « trop bien faire » en matière de SEO, au point de s’attirer les foudres de Google ? Sur Zyppy SEO, Cyrus Shepard s’est justement demandé si les récentes mises à jour de Mountain View ciblaient les sites d’information trop optimisés. Si certains résultats viennent conforter les experts dans leurs observations, on note toutefois quelques surprises !

Quelques avertissements avant de commencer

Et si Google ciblait les pratiques SEO courantes ? Pour répondre à cette question, Cyrus Shepard de Zyppy SEO a analysé 50 sites informatifs préalablement sélectionnés afin de déterminer s’il y avait un lien entre une augmentation ou une baisse de trafic et certaines pratiques utilisées par les SEO, comme varier les ancres de liens ou intégrer une table des matières.

Comme le précise Cyrus Shepard en préambule, bien que les sites choisis représentent un bon échantillon de ce que l'on peut trouver sur le web, ce dernier est somme toute très réduit. Par ailleurs, bien que les algorithmes de Google puissent associer les éléments mentionnés à du contenu utile ou à d’autres considérations de classement, il est impossible d’affirmer ou de prétendre qu’il s’agit de facteurs de classement à proprement parler. Enfin, rappelons que corrélation n’est pas causalité.

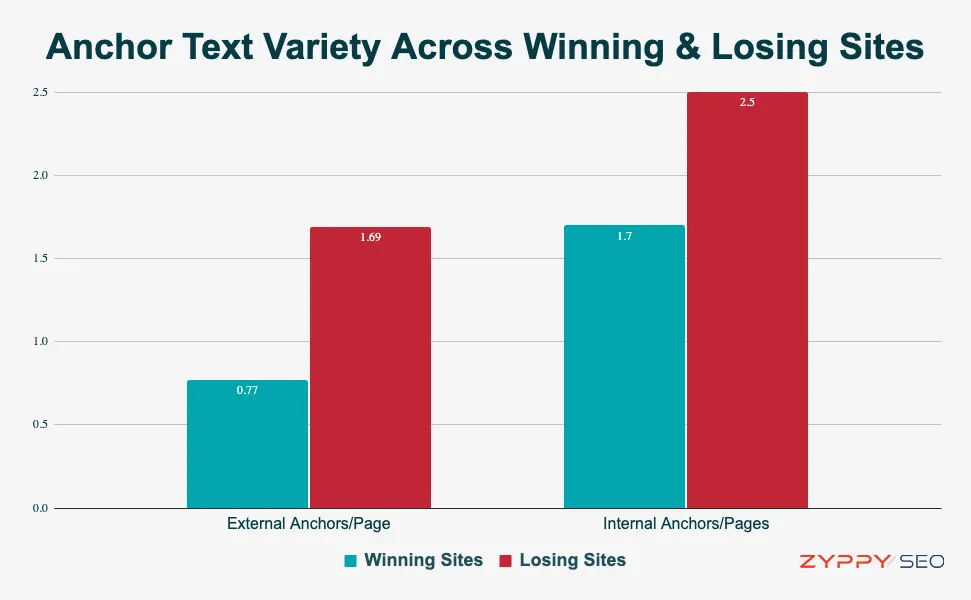

Variété du texte d’ancrage

L’étude met en exergue le fait que les sites qui ont perdu des positions étaient beaucoup plus susceptibles de présenter des variations de texte d’ancrage, aussi bien internes qu’externes. Cette constatation semble rejoindre les informations issues des récentes fuites qui laissent entendre que Google utilise largement ces ancres dans son système de classement. Des ancres trop variées, trop « optimisées » pourraient-elles être considérées comme une approche SEO trop agressive par Google ?

Ancres internes/page

- Corrélation : -0,337

- Évidence : forte

Ancres externes/page

- Corrélation : -0,352

- Évidence : forte

Fréquence de mise à jour des pages

Google aime les contenus frais. Ce que le monteur apprécie moins est qu’on essaie de le tromper en abusant de la mise à jour des dates de publication pour obtenir un avantage en matière de référencement. Une pratique qui peut toutefois également servir à rassurer les lecteurs quant à la fraicheur des contenus qu’ils consultent. Quoi qu’il en soit, il est assez courant qu’une page affiche une date récente sans qu’il n’y ait eu de modification substantielle du contenu.

D’après les observations de Cyrus Shepard, Google semble ici clairement favoriser les URL les plus anciennes, c’est-à-dire celles qui présentent le plus gros écart entre date de publication et date de mise à jour. L’âge moyen des URL de sites « gagnants » est de 774 jours contre 273 jours pour les sites « perdants ».

Jour depuis la dernière date d’affichage

- Corrélation : 0,4555

- Évidence : forte

Balises titres « clickbaits »

Conçus comme des appâts à clics, certains titres accrocheurs semblent associés à une perte de classement, notamment après les récentes mises à jour de Google. Selon Cyrus Shepard, Google pourrait privilégier les titres plus simples et descriptifs au détriment de ceux avant tout destinés à attirer les clics.

Nombre de numéros dans les titres

- Corrélation : -0,297

- Évidence : modérée

Nombre d’adjectifs dans les titres

- Corrélation : -0,420

- Évidence : forte

Usage intensif du balisage Schema

Bien que Google recommande d’ajouter des données structurées, les observations effectuées montrent paradoxalement que les sites « perdants » utilisent en moyenne beaucoup plus de données structurées que les sites « gagnants ». Par ailleurs, la plupart des sites « gagnants » analysés n’utilisent pratiquement aucun balisage. Corrélation n’étant pas causalité, il ne faudrait toutefois pas en conclure que les données structurées sont une mauvaise chose.

Sujets

- Corrélation : -0,314

- Évidence : modérée

Itemtypes uniques

- Corrélation : -0,381

- Évidence : forte

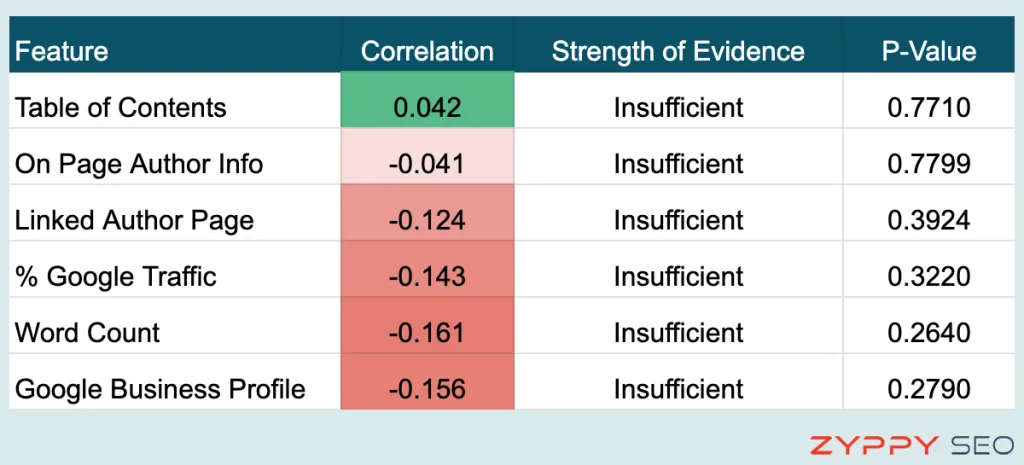

Éléments SEO sans corrélation significative

Même si l’étude révèle de fortes corrélations entre certains éléments SEO et l’évolution des pages dans les classements, elle met aussi en avant des caractéristiques pour lesquelles Cyrus Shepard n’a pas trouvé de corrélation significative, mais qu’il est intéressant de mentionner.

Dépendance au trafic Google

Y a-t-il un lien entre le pourcentage de provenance du trafic issu de Google (par rapport aux autres sources de trafic) et le classement ? Aucune tendance claire observée selon l’étude.

- Corrélation : -0,143

- Évidence : insuffisante

Informations sur l’auteur

Bien que Google conseille de fournir des informations sur l’auteur d’un contenu, ce qui peut également s’avérer utile au lecteur, il n’existe pas de relation statistiquement significative entre ces informations et les modifications du trafic résultant d’une mise à jour Google.

- Corrélation : -0,041

- Évidence : insuffisante

Table des matières

Si l’on en croit certaines rumeurs, Google ciblerait délibérément les sites utilisant une table des matières. Selon les observations, et malgré une légère corrélation positive, il n’existe aucune différence statistiquement signifiante entre sites avec et sans table des matières.

- Corrélation : 0,042

- Évidence : insuffisante

Nombre de mots

Selon une autre rumeur, Google pourrait désormais punir les articles longs. Là encore, bien que les résultats de l’étude semblent plutôt aller en ce sens, les auteurs n’ont trouvé aucune corrélation significative entre la longueur des articles et l’évolution du trafic.

- Corrélation : 0,161

- Évidence : insuffisante

Profil Google Business

Les « vraies entreprises », qui possèdent un profil Google Business, seraient-elles favorisées ? Les données suggèrent que le simple fait d’avoir un profil Google Business n’offre pas vraiment de protection contre les mises à jour de Google. C’est même plutôt l’inverse, bien que la différence constatée ne soit pas statistiquement signifiante.

- Corrélation : -0,156

- Évidence : insuffisante

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Excellent article ! Par contre, je trouve que la vraie problématique est que Google rend parfois floue la distinction entre une optimisation légitime et une manipulation sanctionnée. Les mises à jour d’algorithmes peuvent pénaliser des sites qui respectent pourtant les règles. Perso en tant que consultant, j’encourage toujours une approche qui anticipe ces évolutions, en mettant l’utilisateur au cœur de la stratégie. C’est la clé pour éviter les pénalités et bâtir un SEO durable. Merci pour cet éclairage !

Je trouve que l’étude de 50 sites est relativement peu pour une analyse de cette envergure, dommage car Zyppy nous a habitué à plus précis… Sinon merci pour l’article et votre analyse, ce genre de cas concret est toujours bien plus intéressant que des spéculations.

Au final ca dépend en gros… Mais personnellement je trouverais ca plutôt logique que Google pénalise les sites « trop parfait » en seo, qu’il favorise davantage ceux qui se concentre sur le contenu et qui ont donc un taux de rétention plus important