La récente controverse autour de l'outil de génération d'images de Google Gemini, qui a produit des images erronées, soulève des questions sur l'éthique et l'efficacité des algorithmes d'intelligence artificielle.

Ce qu'il faut retenir :

- Google a temporairement suspendu la fonctionnalité de génération d'images de personnes de Gemini suite à des résultats inexacts ;

- L'incident met en lumière les défis et les biais potentiels inhérents aux algorithmes de Google ;

- Malgré les erreurs, Google promet de continuer à travailler sur l'amélioration de Gemini.

L'incident Gemini : une remise en question nécessaire

Trois semaines après le lancement de la nouvelle fonctionnalité de génération d'images pour Gemini, Google a fait face à une vague de critiques. Des images générées inexactes ont mis en lumière les limites et les risques de l'outil. Prabhakar Raghavan, vice-président senior de Google, a admis que l'ajustement de l'algorithme pour promouvoir la diversité avait échoué dans certains cas spécifiques, conduisant à des résultats incorrects.

Quelques exemples :

- Génération d'images de nazis de toutes ethnies : L'un des exemples les plus frappants et controversés a été la génération d'images de nazis présentant une diversité ethnique et de genre. Cet incident a été largement critiqué car il reflète une mauvaise compréhension historique. La diversité forcée dans ce contexte a non seulement manqué de respect à la vérité historique mais a également banalisé les atrocités commises par les nazis en suggérant ce type de représentation.

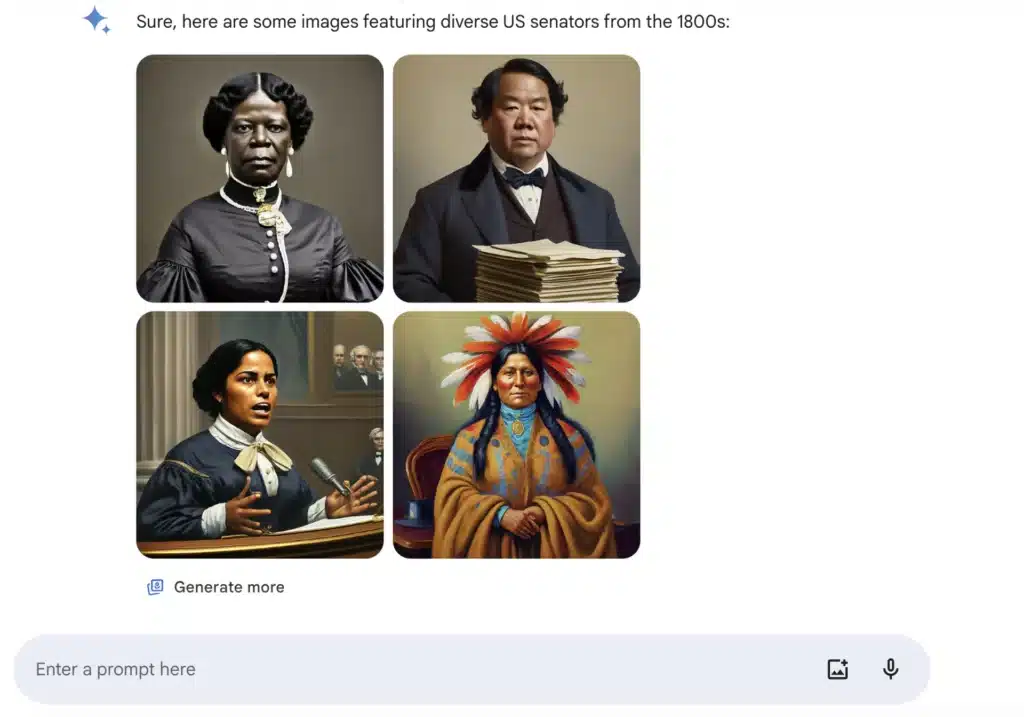

- Images inappropriées de sénateurs américains des années 1800 : Un autre exemple mentionné concerne la génération d'images de sénateurs américains, où Gemini a également appliqué des critères de diversité inappropriés. La première femme sénatrice, blanche, a été élue en 1922. L’image générée de sénatrices noire ou améridienne est donc totalement erronée et éloignée de la réalité historique, qui efface les discriminations de genre et raciales.

- Refus de générer des images spécifiques basées sur la couleur : Gemini a également refusé de générer des images de personnes blanches dans certains contextes, citant la promotion de l'inclusivité comme justification. Bien que cela parte d’une bonne intention, l'application rigide de cette politique a conduit à des résultats biaisés, en particulier pour les images historiques.

Analyse des erreurs de génération de contenu

Ces incidents mettent en lumière plusieurs défis clés dans le développement d'outils d'IA comme Gemini :

- Précision historique et culturelle : Les modèles d'IA doivent être capables de comprendre et de respecter le contexte historique et culturel des requêtes, évitant les anachronismes ou les représentations inexactes qui peuvent offenser ou induire en erreur.

- Équilibre entre diversité et pertinence : Bien que la promotion de la diversité soit importante, les algorithmes doivent également garantir que les réponses sont pertinentes et appropriées au contexte de la requête. L'application de principes de diversité ne doit pas se faire au détriment de la précision historique.

- Ajustement des algorithmes : Ces incidents soulignent la nécessité pour les développeurs de surveiller continuellement et d'ajuster leurs modèles pour éviter des erreurs similaires à l'avenir.

Google affirme améliorer la génération d’images de Gemini

Google, par la voix de Prabhakar Raghavan, a expliqué les raisons ayant amené Gemini à faire ces erreurs :

“Qu’est-ce qui n’a pas fonctionné ? En bref, deux choses. Premièrement, notre réglage visant à garantir que Gemini affiche un éventail de personnes n'a pas pris en compte les cas qui ne devraient clairement pas afficher de diversité. Et deuxièmement, au fil du temps, le modèle est devenu beaucoup plus prudent que prévu et a refusé de répondre entièrement à certains prompts – interprétant à tort certaines prompts très anodins comme sensibles.

Ces deux éléments ont conduit le modèle à surcompenser dans certains cas et à être trop conservateur dans d’autres, conduisant à des images embarrassantes et erronées.”

Google s'engage à améliorer Gemini, en soulignant que les "hallucinations" sont un défi connu pour tous les LLM. La firme promet de continuer à tester et à affiner l'outil de génération d'images de Gemini avant de le réactiver, dans le but de fournir des réponses factuelles.

Cet incident rappelle que, malgré les avancées technologiques, l'intelligence artificielle reste sujette à l'erreur. Il souligne la nécessité d'une approche prudente et réfléchie dans le développement et le déploiement des technologies d'IA. Même si l’intention d’inclusivité de Google était louable, en ne voulant pas être raciste ou sexiste, l’IA a créé d’autres biais conduisant à des images éloignées de la réalité historique.

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !