Dans un post publié sur Google Search Central le 17 février 2023, Gary Illyes de Google demande solennellement aux propriétaires de sites et aux CDN (Content Delivery Network) d’arrêter d’utiliser des codes de statut 403 et 404 dans le but de réduire la vitesse d’exploration (taux de crawl) de Googlebot. En plus d’être inefficace, cette méthode aurait pour effet d’envoyer un signal contreproductif qui pourrait nuire au site.

« S’il vous plait, ne faites pas ça » ; voilà comment Gary Illyes résume le fond de sa pensée face à une tendance qui ne semble pas vraiment du goût de Google : « Au cours des derniers mois, nous avons remarqué une augmentation du nombre de propriétaires de sites et de plusieurs CDN tentant d’utiliser des 404 et autres erreurs client 4xx (à l’exception de l’erreur 429) destinées à réduire la vitesse d’exploration de Googlebot ».

Une pratique inefficace, voire contreproductive

Dans sa publication sur Google Search Central, Gary Illyes rappelle que le rôle des codes de statut HTTP 4xx est de signaler aux clients que leur requête est fausse ou erronée, mais elles ne signifient pas qu’il y a un problème du côté du serveur en lui-même, et n’ont donc pas d’effet sur la vitesse d’exploration du bot. Seule exception : le code de statut 429 (Too Many Requests), considérée comme une erreur du serveur, renvoyée lorsque ce dernier est surchargé en raison d’un trop grand nombre de requêtes effectuées dans un laps de temps très court.

En plus d’être inefficace, la méthode consistant à renvoyer des codes 403 ou 404 à Googlebot dans l’espoir de limiter son exploration peut même avoir un effet contreproductif. En effet, comme le rappelle Gary Illyes, l’utilisation de ces codes de statut peut entrainer la suppression du contenu dans les résultats de recherche du moteur. Par ailleurs, si le fichier robots.txt renvoie également un code HTTP 4xx, il sera traité comme s’il n’existait pas.

Comment réduire efficacement la vitesse d’exploration de Googlebot ?

Dans sa documentation officielle portant sur la limitation de la vitesse d’exploration de Googlebot, Google rappelle qu’il est possible de réduire le taux de crawl en s’appuyant sur l’une des méthodes suivantes :

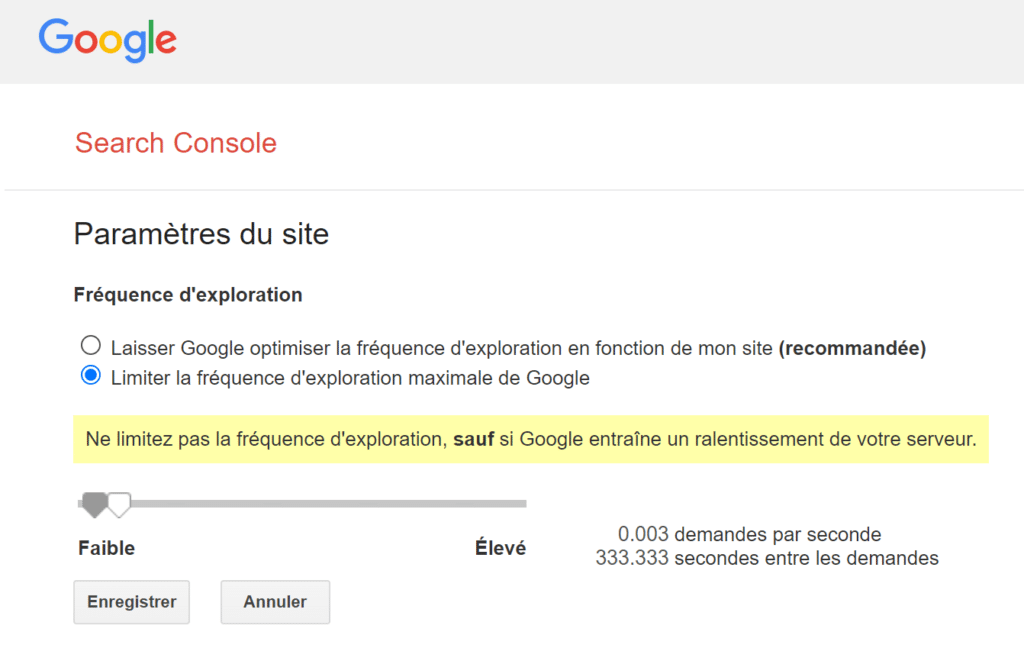

- Demander temporairement la limitation du taux d’exploration via la Search Console. En règle générale, il suffit de quelques jours pour que le changement soit pris en compte. Il est toutefois conseillé de ne pas définir un taux trop faible, au risque de pénaliser le site. Si le paramétrage est impossible, il demeure possible de faire une demande spéciale. En revanche, il est impossible d’utiliser cette demande spéciale pour réclamer une augmentation du taux de crawl.

- Renvoyer un code HTTP 500, 503 ou 429 à Googlebot si sa vitesse d’exploration est trop rapide. Même s’il ne s’agit pas de la solution recommandée en premier lieu par Google, celle-ci peut aider à réduire temporairement le taux de crawl d’un site, pour une période limitée à quelques heures ou quelques jours.

Parfois utilisés pour influencer Googlebot durant son exploration, les codes de statut HTTP 4xx (404, 403, 410 et 418) ne sont pas des solutions viables pour diminuer la fréquence de passages des robots d’exploration. La seule exception est le code de statut 429, à utiliser avec parcimonie, au risque de perdre des positions dans les SERP.

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Merci pour cet article. Dans quelle circonstance, est il intéressant ou utile de demander la réduction du crawl ?

Par exemple si le robot crawle trop vite, engendrant une perte de performances du serveur. Mais c’est assez rare avec Googlebot…