Google, par l'intermédiaire de son porte-parole Gary Illyes, l'avait dit en 2015, il la répété dernièrement : le Web génère 60% de contenu dupliqué. Mais cette statistique énorme se doit d'être analysée...

Google l'avait déjà dit en 2015, et Gary Illyes (qui était déjà la source de l'info il y a 7 ans) l'a répété dans un événement « Google Search Central Live » à Singapour dernièrement : 60% du Web correspond à du contenu dupliqué.

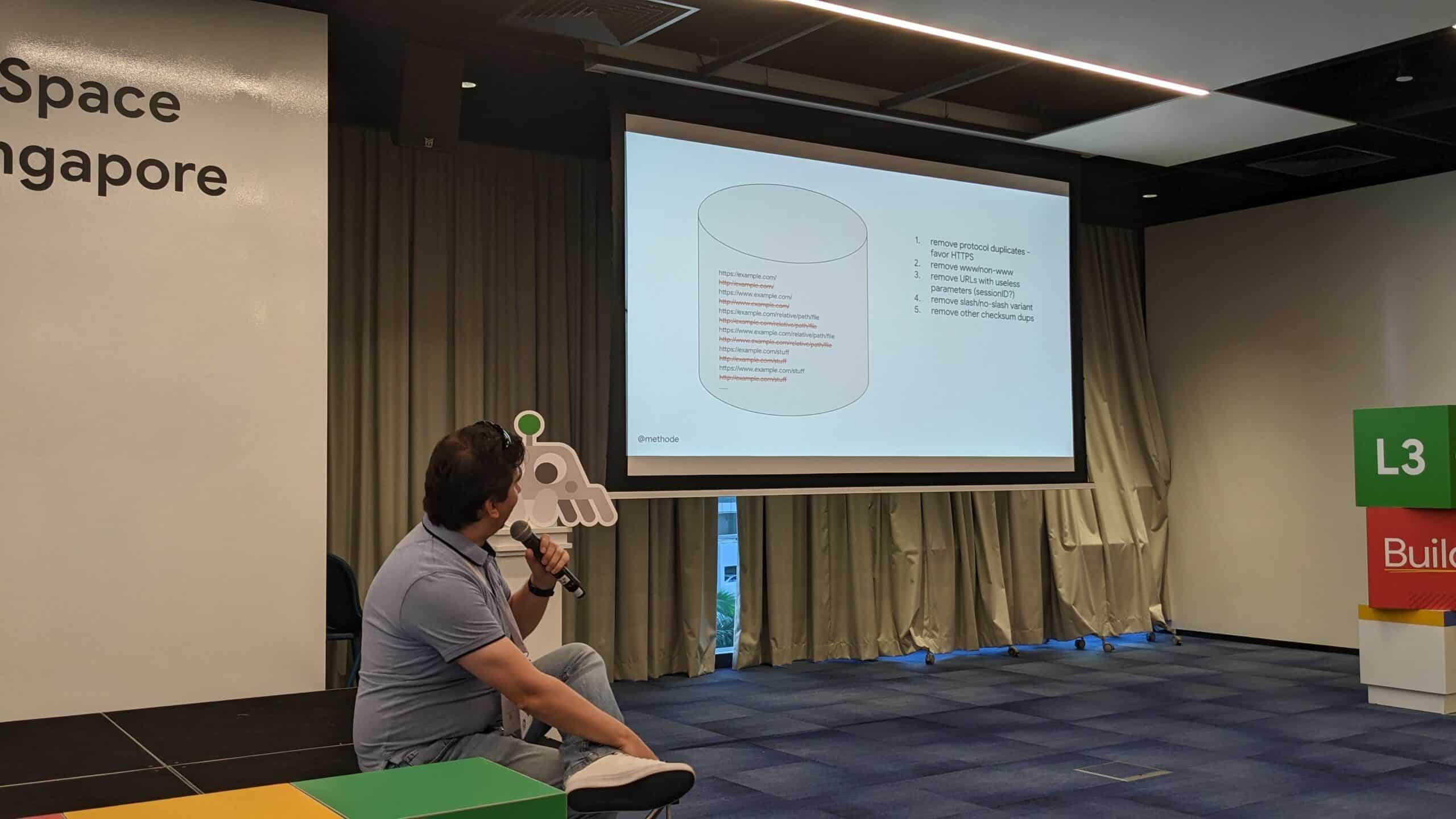

Selon Kenichi Suzuki, présent lors de la conférence de Gary et qui a twitté les illustrations ci-dessous, ce chiffre énorme correspond également aux URL :

- Doublons HTTP/HTTPS ;

- Doublons avec ou sans www ;

- Doublons dus à des paramètres inutiles comme les identifiants de session ;

- Doublons dus à la présence ou non de slash à la fin ;

- Doublons dus à des checksums trop proches (voir notre vidéo sur les checksums) ;

- Etc.

Le duplicate content n'est donc pas uniquement un phénomène touchant le contenu éditorial…

On peut d'ailleurs se rendre compte à quel point le Web génère du contenu dupliqué par défaut en analysant le nombre d'URL refusées à l'indexation dans la Search Console d'un site. Le nombre est parfois énorme !

Slide de Gary Illyes sur le contenu dupliqué. Source : Twitter

Autre slide de Gary Illyes sur le contenu dupliqué. Source : Twitter

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

C’est vrai mais ça gêne pas vraiment je trouve que le meilleurs gagne.

Effectivement, je confirmes et c’est parfois un vrai casse-tête et la nécessité d’un empilage d’algorithmes pour diminuer le problème, auquel s’ajoute le spamdexing et le duplicate-content, les MFA, les fichiers robots txt qui n’acceptent que Google et Bing, etc…

Purement, on frôle les 80% de « déchets » issue du crawl, sur notre dernier crawl de 8 millions de sites Français.

Sur le nouveau crawl de Nov 2022, bientôt mis en ligne, sur 640 millions de pages crawlées, nous avons déjà supprimé 480 millions de l’index.

Certains sites officiels ont une indexation réservée a Google, Bing, tel que legifrance, la page d’index du crawl basique ayant un méta « noindex ». Contacté par email, le site ne réponds pas…

Le problème de faire un moteur n’est pas tant la technologie, mais la difficulté porte sur la masse de déchets et d’arriver a obtenir déjà un index « propre », difficulté que seul Google arrive a surmonter pour le moment.

Mais on ne baisse pas les bras ^^