Un article publié hier par Google explique à quel point les deux derniers algorithmes de Google MUM et BERT tissent leur toile pour supprimer des SERP les résultats choquants ou spammy. L'impact de l'intelligence artificielle dans les résultats de recherche devrait se faire encore plus grand dans les mois qui viennent...

Google a publié un article hier, expliquant comment l'Intelligence Artificielle, et notamment les algoritmes MUM et BERT étaient utilisés dans ses algorithmes pour lutter contre le spam et éliminer des résultats de recherche tout contenu potentiellement choquant ou dangereux.

Google prend l'exemple des personnes en situation de crise personnelle et explique comme le moteur fonctionne dans ce cas : « Désormais, grâce à notre dernier modèle d'IA, MUM, nous pouvons détecter automatiquement et avec plus de précision un plus large éventail de recherches de crises personnelles. MUM peut mieux comprendre l'intention derrière les questions des gens pour détecter quand une personne est dans le besoin, ce qui nous aide à montrer de manière plus efficace des informations fiables et exploitables au bon moment. Nous commencerons à utiliser MUM pour apporter ces améliorations dans les semaines à venir. »

Le but est également de lutter contre les pages présentant des contenus violents, choquants ou déplacés : « L'un des moyens d'y parvenir est le mode SafeSearch, qui offre aux utilisateurs la possibilité de filtrer les résultats explicites. Ce paramètre est activé par défaut pour les comptes Google des personnes de moins de 18 ans. Et même lorsque les utilisateurs choisissent de désactiver le mode SafeSearch, nos systèmes réduisent toujours les résultats racoleurs indésirables pour les recherches qui ne les recherchent pas. En fait, chaque jour, nos algorithmes de sécurité améliorent des centaines de millions de recherches dans le monde entier, en mode Web, image et vidéo. Mais des améliorations sont encore possibles, et nous utilisons des technologies d'IA avancées comme BERT pour mieux comprendre ce que vous recherchez. BERT nous a permis de mieux comprendre si les recherches recherchent réellement du contenu explicite, ce qui nous aide à réduire considérablement les risques de rencontrer des résultats de recherche surprenants. Il s'agit d'un défi complexe auquel nous nous attaquons depuis un certain temps, mais rien qu'au cours de l'année dernière, cette amélioration du BERT a permis de réduire de 30 % les résultats choquants inattendus. Elle s'est avérée particulièrement efficace pour réduire le contenu explicite des recherches liées à l'origine ethnique, à l'orientation sexuelle et au sexe, qui peuvent avoir un impact disproportionné sur les femmes, notamment les femmes de couleur. »

Et l'article continue sur MUM : « MUM peut transférer ses connaissances dans les 75 langues sur lesquelles il a été formé, ce qui peut nous aider à étendre les protections de sécurité dans le monde entier de manière beaucoup plus efficace. Lorsque nous formons un modèle MUM à effectuer une tâche - comme la classification de la nature d'une requête - il apprend à le faire dans toutes les langues qu'il connaît. »

Et notamment l'utilisation de MUM dans le cadre de la lutte contre le spam et les pratiques Black Hat : « Par exemple, nous utilisons l'IA pour réduire les pages de spam inutiles et parfois dangereuses dans vos résultats de recherche. Dans les mois à venir, nous utiliserons le MUM pour améliorer la qualité de nos protections contre le spam et pour nous étendre aux langues pour lesquelles nous disposons de très peu de données d'entraînement. Nous serons également en mesure de mieux détecter les requêtes de crise personnelle dans le monde entier, en travaillant avec des partenaires locaux de confiance pour afficher des informations exploitables dans plusieurs pays supplémentaires. »

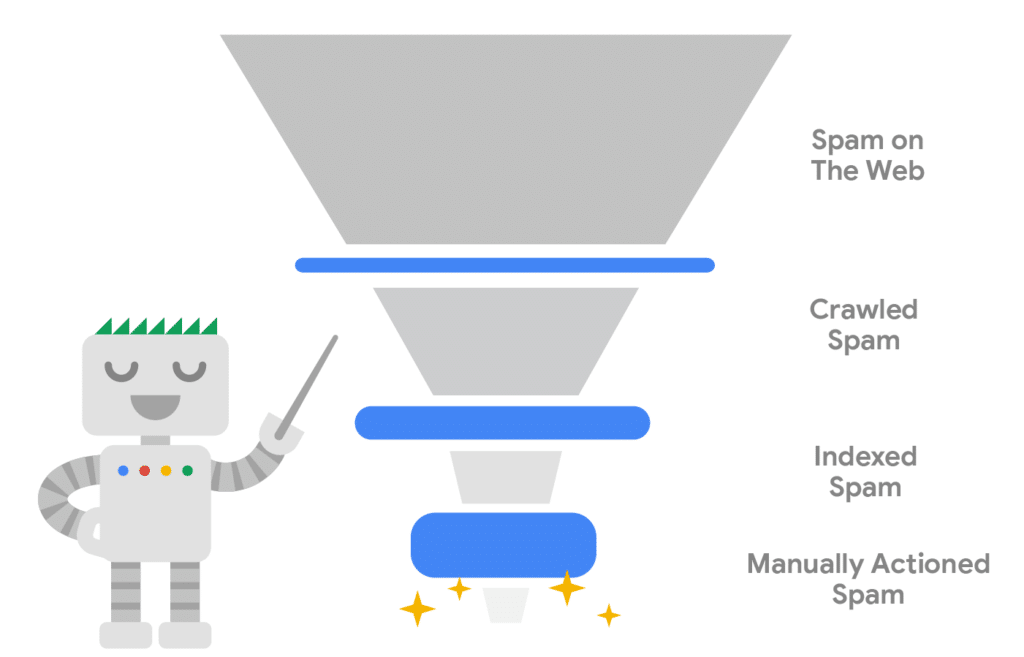

Quand on sait que Google découvre 40 milliards de pages de spam chaque jour, on peut se dire qu'on n'a pas fini de voir MUM et BERT tisser leur toile respective dans les algorithmes du moteur de recherche Google…

Différentes étapes de la détection du spam par Google. Source : Google

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Tout cela s’intègre dans une logique de tri de plus en plus radical du contenu pour Google, avant même son exploration. Son but : réduire son crawl.

Le début d’internet était l’ouverture à tout va de l’information sans aucun contrôle. Désormais, nous passons de plus en plus de temps à gérer les notions réglementaires et normatifs. En outre, la technologie permet un renforcement de la qualité des parutions. On le voit chez les pouvoirs publics, mais aussi du côté des géants du web. À cela,

Les derniers scandales poussent les responsables de Google à prendre des décisions.

Pour les acteurs du référencement, que cela change-t-il ?

Ils doivent tout simplement s’assurer de publier des contenus d’un degré toujours plus élevé, tout en respectant leur industrie. Désormais, il ne s’agit plus de donner une bonne impression pour être indexé, mais d’imaginer qu’ils ne bénéficieront pas de seconde chance.

Bonjour Olivier

L’idée officielle est + que louable, mais n’est ce pas un moyen officieux de contrecarrer les achats de backlinks de basse qualité et donc du spam en clair ?

En effet, à date, même un article faible éditorialement parlant, peut très bien ranker si il y a une campagne « plus ou moins massive » de backlinks de faible qualité (je ne parle pas des mauvais backlinks).

Bien que je ne comprendrai jamais les propriétaires de sites qui utilisent cette technique, car certes ils peuvent bien se positionner dans la SERP de Google, et donc potentiellement avoir du trafic, mais les internautes qui arrivent sur une page de faible qualité vont la quitter de suite, et automatiquement vont faire du pogosticking, et donc quid du ROI ?.

Ils feraient mieux d’investir dans du bon contenu et les bons backlinks viendront tout seul, et le ROI sera vite rentablisé.

Je serais intéressé d’avoir votre avis sur ce point ?

Merci d’avance

Cordialement

Bernard