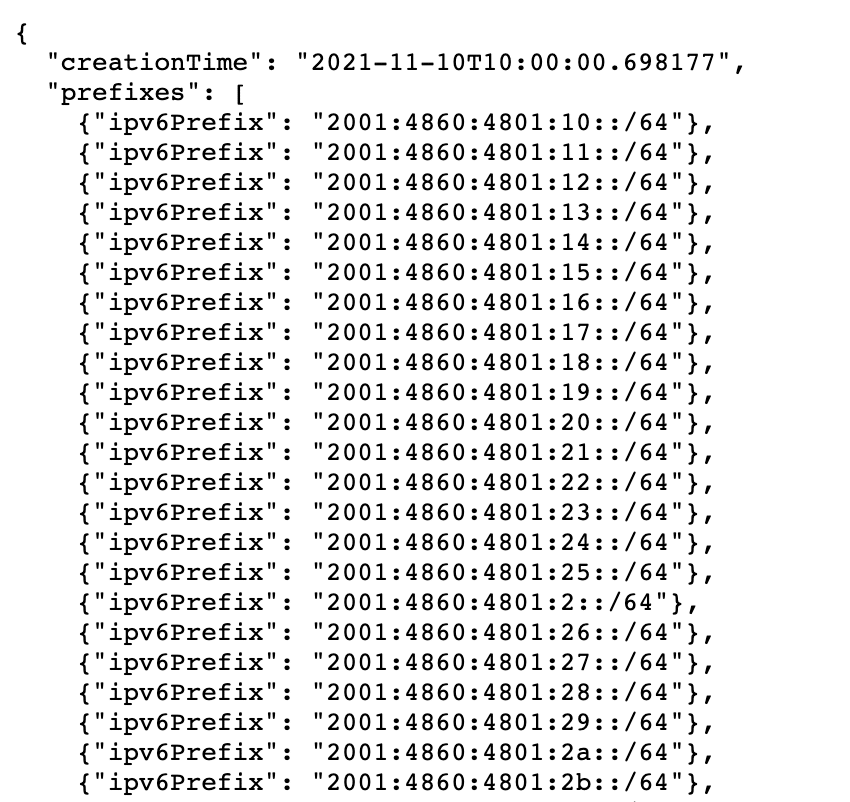

Il était déjà possible de détecter si un robot explorant un site web et se présentant comme Googlebot était réellement un spider officiel. Mais Google vient de publier, sous le forme d'un fichier JSON une liste actualisée des adresses IP qu'il utilise...

L'information existait déjà et était disponible depuis plusieurs années déjà (notamment au travers d'un mécanisme de reverse DNS lookup depuis 2006), mais c'est le format qui semble nouveau. En effet, Google a publié 2 fichiers au format JSON contenant la liste des adresses IP de ses robots d'exploration (Googlebot) :

- Le premier fichier contient la liste des adresses IP de Googlebot : https://developers.google.com/search/apis/ipranges/googlebot.json

- Le second fichier contient la liste de toutes les adresses IP utilisées par Google en général : https://www.gstatic.com/ipranges/goog.json

Et on peut imaginer que cette liste sera mise à jour au fur et à mesure des modifications portées à ces adresses. Alors, pourquoi avoir rendu cette liste publique sous cette forme ? Selon John Mueller, « cela rend les choses un peu plus faciles pour certains sites (CDN, etc.), et les anciens problèmes/risques liés à la dissimulation/cloaking semblent avoir disparu, donc… » Les développeurs white hat pourront en tout cas s'en servir pour vérifier qu'un robot explorant leur site et se présentant comme Googlebot est bien un crawler officiel (ce qui était, rappelons-le, déjà possible auparavant).

Tout a toujours du sens dans la communication officielle de Google, donc finalement, peut-on penser que ce type de liste n'aide pas justement Google à détecter ce type de pratique interdites (pour ce qui est du cloaking interdit en tout cas, puisque certaines formes sont autorisées pour les plateformes JS complexes), justement en crawlant les sites avec des adresses IP qui ne sont pas dans la liste ? La question reste posée…

Extrait de la liste d'adresses IP de Googlebot au format JSON. Source : Google.

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Une bonne nouvelles pour nos développeurs ! 🙂