En avril dernier, Google annonçait un formulaire permettant à certains bêta-testeurs de signaler des bugs d'indexation aux équipes de Google. Cet outil vient de s'ouvrir à tous les webmasters américains. Encore un petit effort pour l'ouvrir au monde entier et ça sera parfait...

Il avait été annoncé en avril dernier mais il n'était disponible qu'à une poignée de « happy fews » et seulement aux États-Unis : le formulaire de signalement de bugs d'indexation du moteur de recherche est désormais disponible à tous les webmasters basés outre-Atlantique.

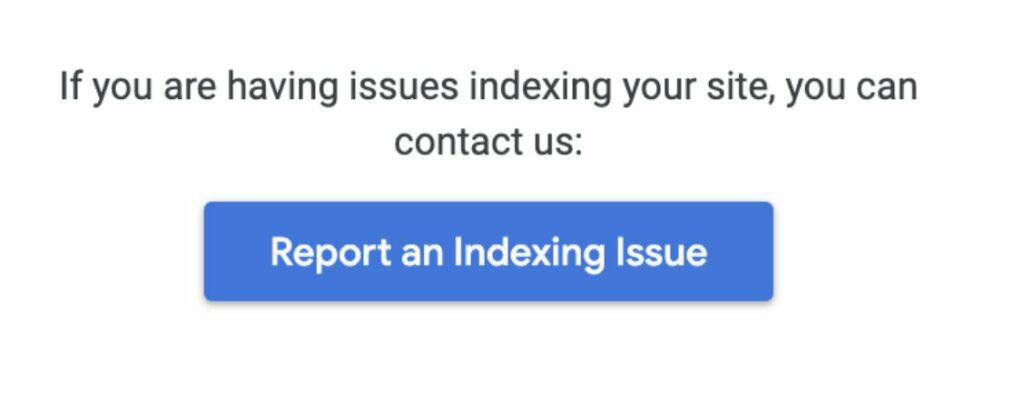

Annoncé officiellement sur Twitter hier, il est disponible sous la forme d'un bouton dans l'aide en ligne sur le rapport de couverture de l'index et sur l'outil d'inspection d'URL.

Bouton donnant accès au formulaire d'indication de problème d'indexation. Source : Search Engine Land.

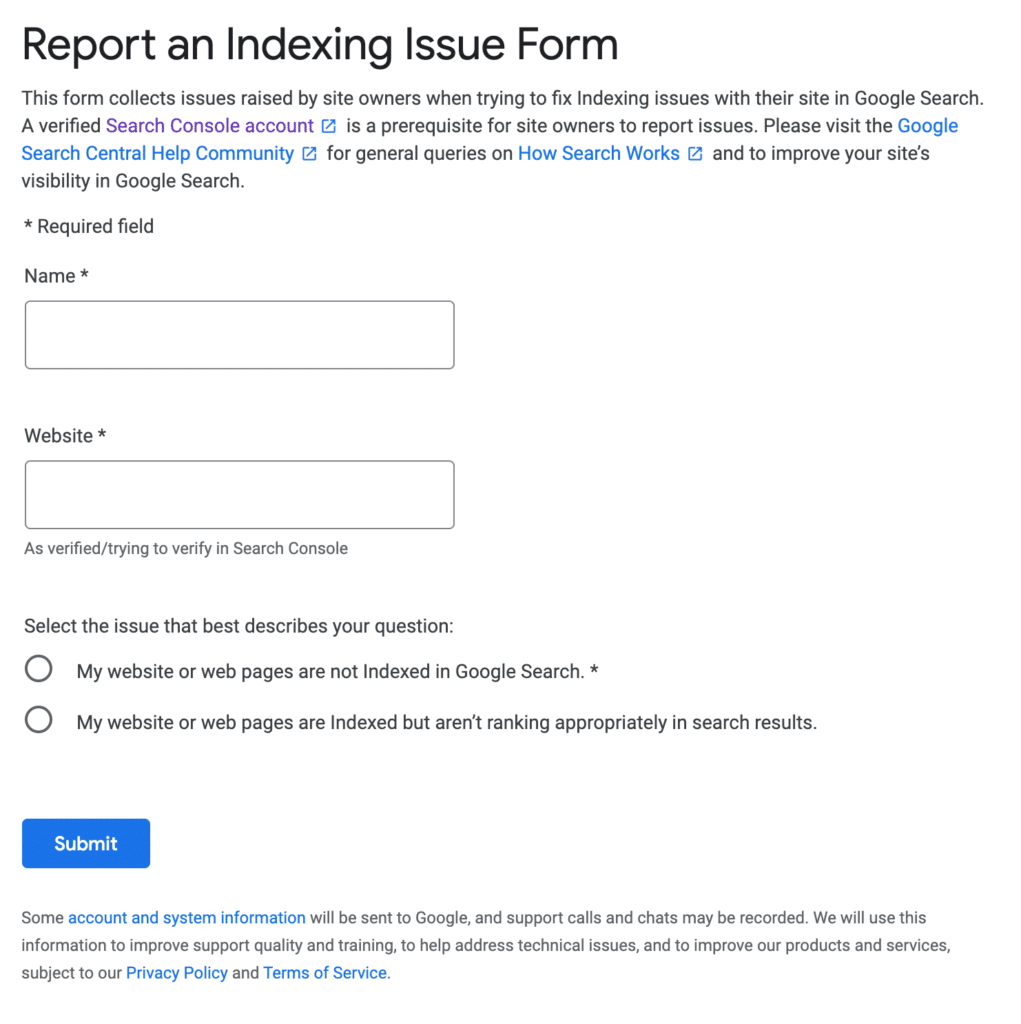

Le bouton donnant accès au formulaire suivant :

Formulaire d'indication de problème d'indexation dans la Search Console. Source : Search Engine Land.

Au fur et à mesure du remplissage du formulaire, des questions sont générées afin que le SEO ou le propriétaire du site puisse ajouter plus de détails sur le problème signalé. "Nous pouvons effectuer un suivi pour obtenir plus d'informations si les faits confirment qu'il s'agit d'un bogue d'indexation réel", indique Google dans les instructions du formulaire. "Nous ne répondrons pas aux autres types de problèmes."

Cette ouverture plus forte de l'outil à tous les webmasters outre-Atlantique est donc une bonne nouvelle. Il ne reste plus qu'à attendre l'étape suivante : une ouverture encore plus large, et notamment en Europe et en France car, à en lire les réseaux sociaux, les bugs d'indexation de Google continuent à poser problème partout, et pas qu'aux États-Unis…

Super article.

On verra bien ce qu’il se passera, en tout cas de notre côté beaucoup de problemes persistant

BOnjour,

J’ai un site « indexable » de mois de 50 pages. Mais mes utilisateurs génèrent des dizaines de milliers de pages (voir plus), que, bien entendu, je disallow dans le fichier robots.txt et je double avec un noindex dans la page elle même à sa création.

Dans la Search console onglet « Couverture » tout était correct jusqu’à présent : moins de 10 pages dans « Indexée malgré le blocage par le fichier robots.txt »

Depuis 7 à 10 jours j’observe, une remontée à chaque mise à jour : j’en suis à 200 pages.

Est ce que quelqu’un remarque aussi ce phénomène ?

Il y a des stats montrant quel part de pages ne sont plus indexées à cause de « bugs » et quel part google ne veut tout simplement plus perdre de temps à indexer (sans même parfois les consulter) ?

Google ne semble donc pas capable de détecter ses propres bugs d’indexation au point de demander aux webmasters ?.. C’est inquiétant.

En quoi, c’est inquiétant ? Cela semble même normal. Tout éditeur logiciel a un support pour remonter les bugs trouvés chez ses clients …