Microsoft dévoile le projet Make Every Feature Binary (MEB), du nom de ce nouvel algorithme, déjà pleinement opérationnel sur le moteur Bing, qui a pour vocation d'améliorer les résultats de recherche en comprenant mieux les requêtes et en analysant de façon plus pointue les contenus...

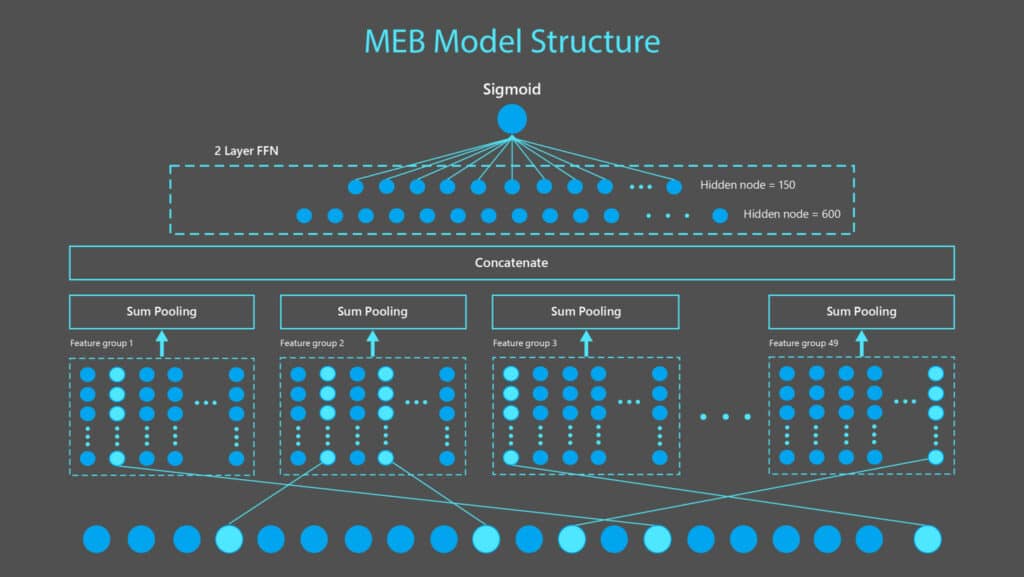

Bing a annoncé récemment le projet "Make Every feature Binary" (MEB), un modèle qui complète ses modèles "Transformer" afin d'améliorer la pertinence des recherches sur son moteur Bing en utilisant l'Intelligence Artificielle AI at Scale. Pour rendre la recherche plus précise et dynamique, MEB exploite mieux la puissance des données disponibles en volume important et permet un espace de caractéristiques d'entrée avec plus de 200 milliards de caractéristiques binaires qui reflètent les relations entre les requêtes de recherche et les documents disponibles sur le Web.

Voici quelques explications fournies par les équipes de Microsoft sur le projet MEB : "L'une des raisons pour lesquelles MEB fonctionne si bien en complément des modèles d'apprentissage profond basés sur Transformer pour la pertinence de la recherche est qu'il peut mettre en correspondance des faits individuels avec des caractéristiques, ce qui permet à MEB d'acquérir une compréhension plus nuancée des faits individuels. Par exemple, de nombreux modèles linguistiques de deep neural network (DNN) pourraient surgénéraliser en remplissant le blanc de cette phrase : "(blanc) peut voler." Étant donné que la majorité des cas d'apprentissage DNN aboutissent à "les oiseaux peuvent voler", les modèles de langage DNN pourraient ne remplir le blanc qu'avec le mot "oiseaux".

La MEB évite cela en assignant chaque fait à une caractéristique, de sorte qu'elle peut attribuer des poids qui distinguent la capacité de voler chez, disons, un pingouin et un macareux. Il peut le faire pour chacune des caractéristiques qui rendent un oiseau - ou toute entité ou objet d'ailleurs - singulier. Au lieu de dire "les oiseaux peuvent voler", la MEB associée aux modèles Transformer peut passer à un autre niveau de classification, en disant "les oiseaux peuvent voler, sauf les autruches, les pingouins et ces autres oiseaux".

Il s'agit également d'améliorer la méthode d'utilisation des données de manière plus efficace à mesure que l'échelle augmente. Le classement des résultats Web dans Bing est un problème d'apprentissage automatique (machine learning) qui bénéficie de l'apprentissage sur d'énormes quantités de données utilisateur. Une approche traditionnelle pour exploiter les données de clics consiste à extraire des milliers de caractéristiques numériques artisanales pour chaque couple requête/document impressionné et à entraîner un modèle d'arbre de décision boosté par gradient (gradient boosted decision tree ou GBDT).

Cependant, même l'entraîneur GBDT de pointe, LightGBM, converge après des centaines de millions de lignes de données, en raison de la représentation limitée des caractéristiques et de la capacité du modèle. De plus, ces caractéristiques numériques fabriquées à la main ont tendance à être très grossières par nature. Par exemple, elles peuvent capturer le nombre de fois que le terme à une position donnée dans la requête apparaît dans le document, mais les informations sur la nature du terme spécifique sont perdues dans cette représentation. En outre, les caractéristiques de cette méthode ne prennent pas toujours en compte de manière précise des éléments tels que l'ordre des mots dans la requête de recherche.

Afin d'exploiter la puissance d'énormes données et de permettre une représentation des caractéristiques qui reflète mieux les relations entre les requêtes et les documents, MEB est entraîné avec plus de 500 milliards de paires requête/document provenant de trois années de recherches sur Bing. L'espace des caractéristiques d'entrée compte plus de 200 milliards de caractéristiques binaires. Avec FTRL, la dernière version est un modèle de réseau neuronal clairsemé avec 9 milliards de caractéristiques et plus de 135 milliards de paramètres."

Un modèle actuellement utilisé par Bing

Les équipes de Microsoft continuent en expliquant que le modèle MEB est actuellement totalement fonctionnel sur Bing : "MEB fonctionne en production pour 100 % des recherches Bing, dans toutes les régions et dans toutes les langues. C'est le plus grand modèle universel que nous utilisons chez Microsoft, et il démontre une excellente capacité à mémoriser les faits représentés par ces caractéristiques binaires tout en apprenant de manière fiable et continue à partir de grandes quantités de données.

Ces relations apprises par la MEB sont très complémentaires de celles apprises par les modèles DNN basés sur le Transformer. Les avantages pour la pertinence de la recherche et l'expérience de l'utilisateur sont très clairs. L'introduction de MEB en plus de nos modèles Transformer de production a eu pour résultat :

- Une augmentation de presque 2 % du taux de clics (CTR) sur les premiers résultats de recherche. Ces résultats se trouvent "au-dessus de la ligne de flottaison" sans qu'il soit nécessaire de les faire défiler.

- Une réduction de la reformulation manuelle des requêtes de plus de 1 %. Le fait que les utilisateurs doivent reformuler manuellement leurs requêtes signifie qu'ils n'ont pas aimé les résultats obtenus avec leur requête initiale.

- Une réduction de plus de 1,5 % des clics sur la pagination. Le fait que les utilisateurs doivent cliquer sur le bouton "page suivante" signifie qu'ils n'ont pas trouvé ce qu'ils cherchaient sur la première page."

Si vous voulez en savoir plus sur MEB, nous vous encourageons à lire l'article qui présente ce projet en détail sur le site de Microsoft.

Structure du modèle MEB par Microsoft. Source : Microsoft.