5 ans après sa première annonce sur le sujet, Google vient d'annoncer que son robot Googlebot allait enfin commencer à crawler certains sites disponibles selon le protocole HTTP/2 (h2). Pas de gain à attendre en termes de positionnement, mais la phase de crawl devrait y gagner en efficacité...

Google l'a annoncé la semaine dernière : à partir de la mi-novembre (soit dans deux mois environ), Googlebot va commencer à crawler les sites disponibles selon le protocole HTTP/2 (ou h2 pour les intimes).

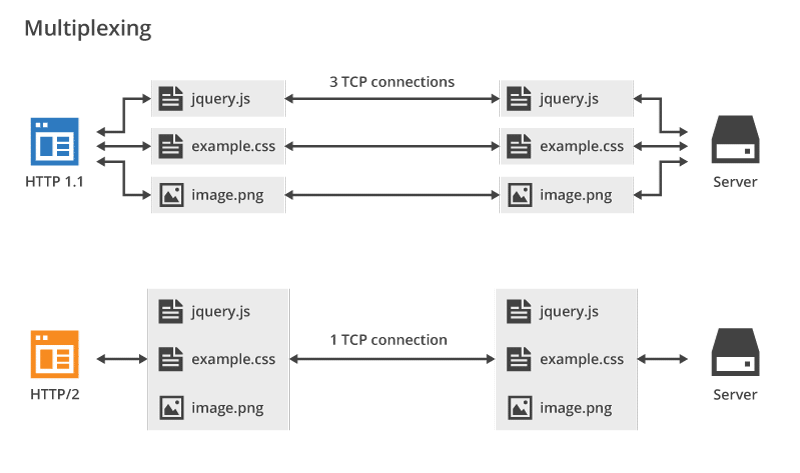

HTTP/2 est la nouvelle version du protocole HTTP, qui n'avait pas connu de forte évolution depuis presque 20 ans (la version 1.1 date de… la fin des années 90 !) et se veut plus fiable, plus rapide, en un mot plus efficace. Attendu depuis des années, Googlebot semble vouloir se mettre à enfin crawler les sites déjà disponibles en HTTP/2, notamment avec un système permettant de crawler plusieurs fichiers en parallèle au travers d'une simple connexion (au lieu de plusieurs en HTTP 1.1), ce qui allège la charge serveur.

Google a expliqué que le nombre de sites crawlés en HTTP/2 sera faible au départ, pour monter en charge au fil du temps, et il choisira ces sites en fonction de plusieurs critères (le site accepte-t-il ce protocole ? Quel bénéfice peut-il en tirer ? Même question pour Googlebot ? Etc.) et explique qu'il ne devrait pas y avoir d'impact négatif sur le crawl et l'indexation (encore heureux, ce n'est pas le but !).

Google ne crawlera le site en h2 que s'il estime qu'il y a un bénéfice à cela et si c'est le cas, un message sera envoyé dans la Search Console. Sinon, il continuera en h1. Et vous ne pouvez pas demander à Google de crawler en priorité votre site en h2. Il faut attendre le bon vouloir de Googlebot pour cela. Si vous ne voulez pas que votre site soit crawlé selon le nouveau protocole, vous devez renvoyer un code 421 (Misdirected Request) lors de ses tentatives.

Notons que cette annonce avait déjà été faite… en novembre 2015 ! Comme quoi, il n'est jamais trop tard pour bien faire 🙂

Et rappelons qu'un crawl en HTTP/2 n'a pas d'influence sur les classements. Il ne s'agit pas d'un critère de pertinence de l'algorithme 😉

Un des avantages de HTTP/2 : le multiplexing. Source : Cloudflare

Oui, on verra déjà avec les Core Web Vitals en 2021…

A lire à ce sujet : https://www.abondance.com/20200529-42880-core-web-vitals-lux-sera-t-il-bientot-pris-en-compte-par-google-prenons-du-recul.html

Bonjour Olivier,

Est-ce d’après vous « Et rappelons qu’un crawl en HTTP/2 n’a pas d’influence sur les classements. Il ne s’agit pas d’un critère de pertinence de l’algorithme » cela veut dire « Pour le moment ce n’est pas un critère de pertinence » ???

Thierry

Rien de nouveau à l’horizon et a priori rien n’est prévu dans ce sens (ce qui serait assez logique)

Pourquoi logique ?

J’ai lu, je ne peux pas corroborer, que l’on pouvait gagner jusqu’à 30% de temps d’échange de données avec le protocol HTTP2, ce n’est pas négligeable.

Google cherchant toujours à optimiser pour des raisons de coût je suppose que cela peut leur rendre service d’économiser 30% de bande passante.

Vous ne pensez pas ?

Thierry

Qu’un site web rende service à Google en lui faisant économiser des ressources donc de l’argent, je n’en doute pas une seconde 🙂

Qu’un site web rapide réponde de façon pertinente à l’intention de recherche de l’utilisateur d’un moteur, c’est beaucoup plus discutable et beaucoup moins logique. C’est pour ça que la « web performance » ne sera jamais – si ça arrive un jour – qu’un critère de pertinence très mineur dans l’algorithme.

Sauf si Google dit un jour : « ce site me fait gagner de l’argent, donc je le classe mieux ». Mais là, ce sera une autre histoire… 😉

Merci pour cette réponse Olivier ! 🙂

Après je ne pense pas qu’un jour Google dise « ce site me fait gagner de l’argent, donc je le classe mieux », cela serait un peu mauvais pour leur image …

Rappelons-nous de cette discussion et l’avenir nous dira si la « web performance » devient un critère significatif ou non 😉

Thierry