Suite de la vidéo 151 : la semaine dernière, nous abordions la problématique des URL que l'on désire désindexer et la mise en place d'un fichier robots.txt. Mais avant cela, il faut bien penser à désindexer certaines URL que le robot aurait exploré dans le passé. Bref, faire place nette avant d'interdire le crawl aux robots des moteurs. Autant faire les choses dans le bon ordre...

La semaine dernière, nous avons traité la problématique des nombreuses pages très similaires dans leur contenu, ayant une URL répondant à un schéma ("pattern") répétitif et n'ayant que très peu (voire pas du tout) d'intérêt pour votre SEO et qu'il faut donc désindexer.

Mais nous n'avions à cette occasion traité qu'une partir de la question en parlant du fichier robots.txt qui interdit le crawl mais ne gère pas la partie "désindexation" éventuellement, auparavant.

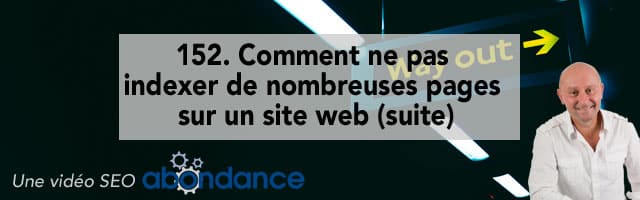

C'est donc le sujet de notre vidéo cette semaine : comment faire en sorte de faire "place nette" sur votre site en désindexant dans un premier temps les URL indésirables, pour interdire dans un second temps, comme expliqué la semaine dernière, le crawl pour les futures tentatives d'exploration par les robots des moteurs de recherche. Plus d'infos donc à ce sujet dans cette 152e vidéo SEO Abondance :

Comment ne pas indexer de nombreuses pages sur un site web (suite) ? Vidéo N°152 proposée par Olivier Andrieu (Abondance). Source : Abondance

|

|

|

|

|

| N'hésitez pas également à visiter la zone "Vidéos SEO" du site et à vous abonner à la chaîne YouTube du site Abondance (ou à son fil RSS) pour découvrir, semaine après semaine, les prochaines vidéos que nous vous proposerons. |

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Bonjour Olivier,

Merci pour cette vidéo. Y a t’il un moyen rapide pour ajouter la balise meta robots « noindex » sur de nombreuses pages (hormis via le X-Robots-Tag) ? Merci 🙂

A voir en fonction du CMS utilisé et d’éventuels plugins disponibles qui font cela ?

Olivier,

ne faudrait-il pas préciser l’usage que tu proposes d’un sitemap dédié aux pages à désindexer ?

L’idée est bien de pousser à Google une liste d’URLs, pour qu’il les crawle plus rapidement, et tombe sur des balises no-index ?

Oui, voilà 🙂

Bonjour Olivier,

Vous ne parlez pas de la solution Noindex: xxxxx dans le robots.txt.

Y a-t-il une raison à cela ?

Merci.

Ce n’est plus maintenu donc obsolète : https://www.abondance.com/20190703-40005-google-veut-standardiser-le-robots-txt-et-abandonne-officiellement-la-directive-noindex.html

Bonjour Olivier,

Après essai, il me semble que les url de type site.com/repertoire/exemple- ne fonctionne pas. En effet, la Search Console ne prend en compte que les répertoires.

Donc si l’adresse soumise ne termine pas par un nom de répertoire suivi de /, ça ne fonctionne pas.

Bizarre, j’ai fait le test avec ce type de pattern d’URL et chez moi, ça a marché parfaitement ?

Je l’ai fait avec https://www.podexpert.com/avis-de- et la demande a bien été prise en compte (Etat : suppression temporaire) pourtant je retrouve bien les pages de type https://www.podexpert.com/avis-de-agnes-sur-chaussures-pieds-sensibles-comfort-class-1404-ac-83.html dans le rapport de couverture dans les pages valides.

Ah ben oui, il faut attendre que la Search Console se mette à jour. En revanche une requête « site:https://www.podexpert.com/avis-de- » doit donner des résultats à jour à ce niveau…

Oui j’ai bien attendu la mise à jour de la Search Console. Il y a eu 3 MAJ depuis l’acceptation de la demande.

Bonjour et merci pour cette nouvelle vidéo.

Les demandes de désindexation ont l’air d’être prise en compte rapidement mais il faut attendre la mise à jour des données de Search Console pour voir ces pages passer dans les Exclues. Je remarque que les données sont mises à jour tout les 4 jours sur mon site. Pourquoi ce délai ? A quoi est-il dû ?

Merci pour votre réponse.

Au volume de données à traiter, je pense ? Ca doit être gigantesque…

Ok. Avez-vous connaissance de site qui ont une mise à jour de leurs données plus régulières et plus rapides ?

Pour manageo.fr aussi on a généralement plusieurs jours de décalage dans l’affichage des données sur la Search Console. Mais ceci lis à part, c’est vraiment un outil précieux pour échanger directement avec Google (recevoir et envoyer des informations).