Le moteur de recherche d'images de Bing est remarquable et représente certainement l'un des meilleurs au monde à l'heure actuelle. Dans un post récent, les équipes de développement de l'outil nous en disent plus sur son mode de fonctionnement et les algorithmes utilisés pour ses dernières innovations...

Bing a dernièrement posté un article très intéressant qui fournit quelques explications sur la façon dont fonctionne sa recherche d'images, avec pour objectif annoncé d'aller vers « un moteur de recherche plus intelligent et plus précis grâce à des recherches multi-granulaires, une meilleure compréhension des requêtes des utilisateurs, des images et des pages Web, ainsi que des relations entre eux ».

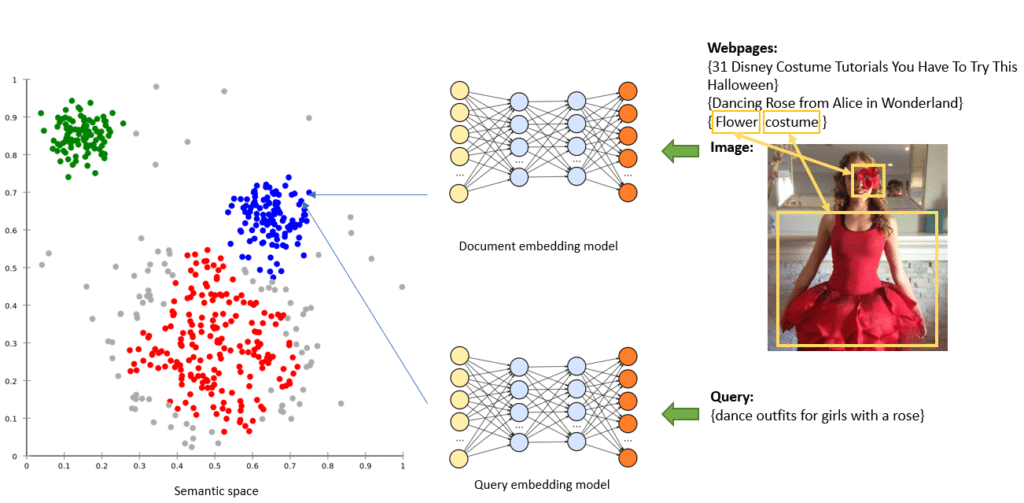

Bing y explique que les algorithmes de deep learning utilisés par son moteur de recherche d'images tentent le plus souvent de résoudre des requêtes complexes ou ambiguës comme par exemple : "l'homme blond avec une moustache" ou "des tenues de danse pour les filles avec une rose". Des technologies comme BERT sont ainsi utilisées pour mieux comprendre le contexte de telles requêtes, comme indiqué dans l'illustration ci-dessous, grâce à l'analyse et la correspondance vectorielle :

Analyse de type BERT pour trouver des images répondant à la requête "des tenues de danse pour les filles avec une rose". Source de l'image : Bing

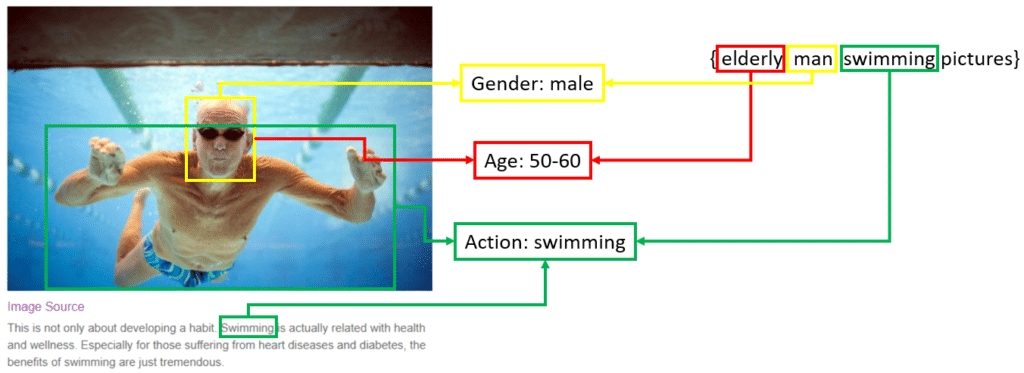

De plus, Bing ajoute des attributs (un peu comme des tags, finalement) qu'il ajoute à l'analyse de l'image et qui va l'aider à comprendre le contenu de la photo et la mettre en relation avec la requête demandée au travers de correspondances les plus précises possibles, comme ici pour la requête "images d'un homme âgé nageant" :

Analyse des attributs de l'information-source pour trouver de simages répondant à la requête "images d'un homme âgé nageant". Source de l'image : Bing

Bing indique cependant que ces technologies n'en sont qu'à leurs débuts et qu'elles ne supportent actuellement qu'un ensemble limité de scénarios et d'attributs.

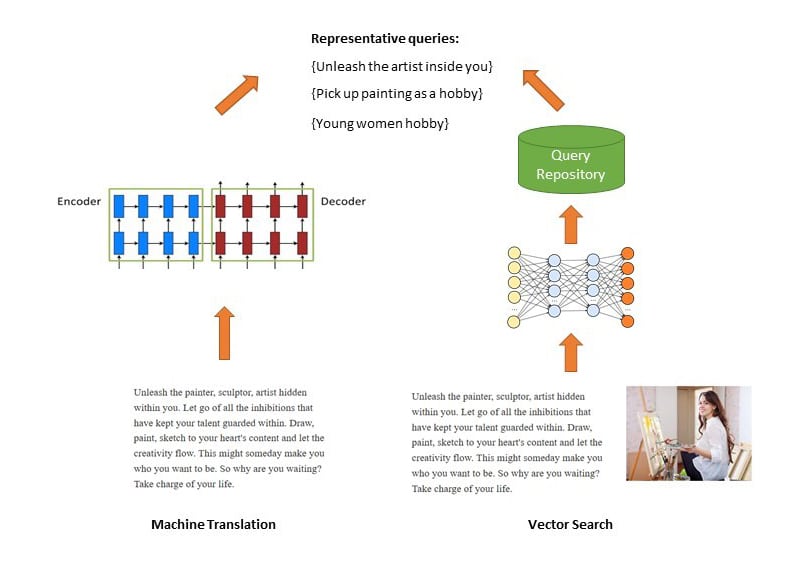

Bien entendu, ces techniques nouvelles s'appuient toujours sur l'analyse des metadonnées "classiques". Parmi celles-ci, on trouve la metadonnée BRQ (pour "Best Representative Query"), soit la requête la plus logique pour identifier l'image en question. Ces informations, également générées par des algorithmes de deep learning, peuvent se baser sur deux méthodes complémentaires :

- Des systèmes de traduction d'un texte long (celui de la page contenant l'image) vers des phrases courtes qui deviennent des requêtes potentielles.

- Des système plutôt basés sur l'analyse vectorielle prenant en compte le texte et l'image en question dans un vecteur sémantique unique avec recherche des termes les plus proches dans un référentiel de requêtes. Ainsi, seules les requêtes à l'intérieur d'un seuil de similarité seront considérées comme représentatives pour cette image.

Recherche des metadonnées de type BRQ sur le moteur de recherche d'images de Bing. Source de l'image : Bing

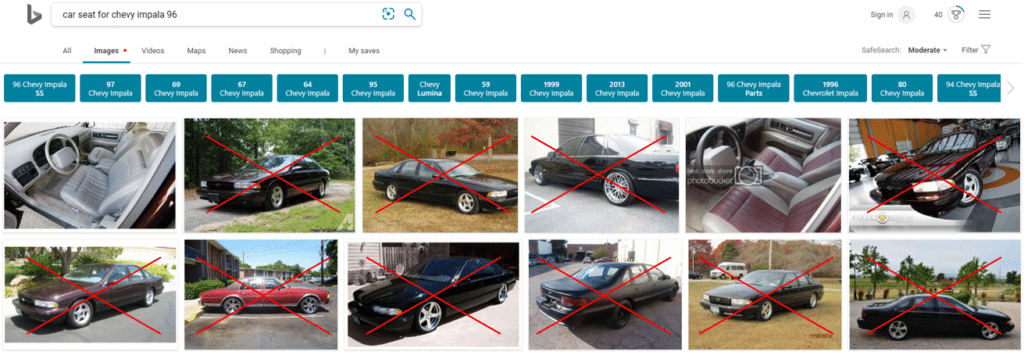

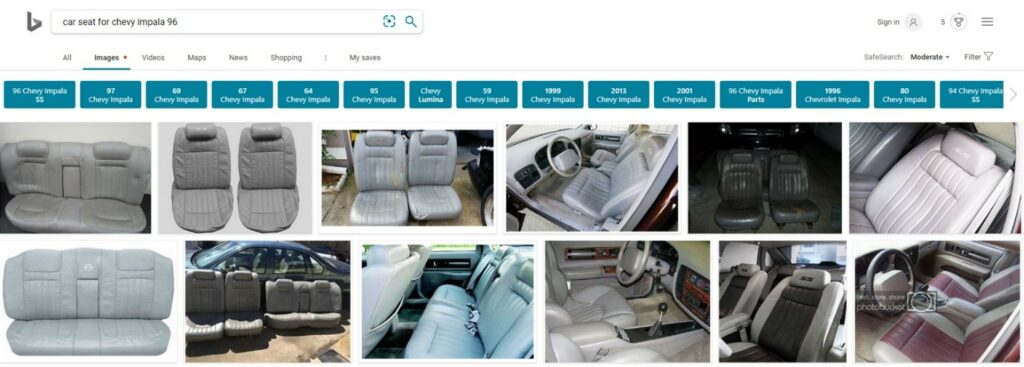

Pour terminer, Bing montre un exemple de résultats améliorés par ces différentes techniques pour la recherche {car seat for Chevy impala 96}. En 2017, de nombreux résultats étaient de faible qualité. Deux ans après, la plupart des images ont un rapport direct avec la requête :

Résultat de recherche Bing Images pour la requête {car seat for Chevy impala 96} en 2017. Source de l'image : Bing

Résultat de recherche Bing Images pour la requête {car seat for Chevy impala 96} en 2019. Source de l'image : Bing

On n'aura de cesse de dire que le travail de Bing sur la recherche d'images est remarquable et que le moteur se situe souvent au-dessus de celui de Google en termes de qualité de résultats et de fonctionnalités de recherche. Et lorsqu'on teste par exemple les possibilités de Visual Search du moteur de recherche de Microsoft, on en est rapidement convaincu...

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Votre article m’a interpelée donc je suis allée faire des essais de recherche sur bing et le moins que l’on puisse dire c’est que sur une requête de mots clefs il est abominablement mauvais !

J’ai testé plusieurs requêtes et la pertinence des images affichées est toujours moins bonne que google.

Il semble que Bing ne prenne pas en compte le contenu textuel des pages associé aux noms des images qui s’y affichent.

Par exemple, si je fais la requête “retouche photo Lyon”, bing affiche beaucoup trop d’images de notre site (je ne devrais pas me plaindre) qui ne sont pas en rapport direct avec la retouche ni par leur nom ni dans les pages qui y sont exclusivement consacrées !

Sur la requête “packshot ghost Lyon” il n’affiche que très très peu d’images en rapport avec le sujet puis affiche des images d’oiseaux ???

On est très loin d’une intelligence artificielle 😉

Il se mélange complètement les pinceaux alors que Google sur ce point s’en sort beaucoup mieux.

Les robots sont de plus en plus « intelligents » aujourd’hui, ils sont pratiquement capable de lire une image. De ce n’y a t il pas un risque que le texte disparaisse des moteurs de recherches ? Dans ce y a t il un risque pour google de perdre son leadership ?