Google a donc annoncé vendredi dernier BERT, une nouvelle avancée de son algorithme visant à mieux comprendre le langage naturel. Voici quelques informations complémentaires sur ce projet, afin d'éviter tout malentendu et mauvaise compréhension et interprétation du « phénomène »...

On a donc appris vendredi dernier que Google allait lancer BERT, une nouvelle mise à jour de son algorithme, la plus forte sur les 5 dernières années, selon la société de Mountain View. A ce sujet, il nous a semblé intéressant de faire ici un point proposant quelques informations complémentaires au sujet de ce BERT, afin qu'il n'y ait pas de malentendus, car plusieurs affirmations, parfois erronées, nous semblent déjà avoir été publiées ces derniers jours.

Tout d'abord, pas de panique. Si le projet BERT est "sur les rails" depuis plusieurs mois (Google avait d'ailleurs communiqué à ce sujet dès novembre 2018), on ne sait pas vraiment (la communication officielle de Google par Pandu Nayak - vice-président du "search" chez Google - ne semble pas si claire que cela à ce sujet) avoir été mis en production encore, ni aux Etats-Unis ni ailleurs. Ceci dit, si BERT n'est pas déjà en ligne, ce n'est certainement qu'une question de semaines pour la langue anglaise.

Il est sûr en revanche que le projet n'est pas encore opérationnel en France, car il a besoin de collecter les données de la langue anglaise auparavant pour asseoir la technologies sur d'autres langues. Mais c'est bien sûr prévu (aucune date officielle n'a cependant été communiquée). La situation aux Etats-Unis et/ou la langue anglaise nous en dira peut-être plus dans les mois qui viennent, avant de passer aux aspects francophones.

BERT, un projet plus révolutionnaire pour Google que pour le SEO

Pas de panique non plus, si ce projet est révolutionnaire, c'est avant tout pour Google et son moteur (et sa "plomberie interne"), car cela lui permettra de mieux appréhender et comprendre les requêtes complexes tapées sur le Web ainsi que les questions posées à l'assistant vocal. Mais cela ne devrait toucher que 10% de ces requêtes, ce qui est à la fois beaucoup et finalement assez peu (cela signifie donc que 90% des requêtes ne seront pas touchées, si on sait bien compter 🙂 ). Et l'immense majorité des requêtes "classiques" ne devraient pas être impactées. BERT cible plus vraisemblablement les expressions longues et "exotiques", pour reprendre un terme utilisé par un googler. En gros, si une requête (ou une question) ne contient que un, deux ou trois mots, il y a peu de chance que BERT soit d'un grand secours. Ce qui laisse pas mal de marge encore...

Rappelons également que BERT (acronyme de Bidirectional Encoder Representations from Transformers) est, à l'instar de RankBrain, par exemple, avant tout conçu pour mieux identifier et analyser, comprendre, les requêtes complexes (longues) et leur contexte. Globalement, cela n'amènera pas de lourds changements sur nos sites web, si ce n'est qu'il faudra continuer à, encore et toujours, proposer un contenu de la meilleure qualité possible pour répondre de façon toujours plus précise et pertinente à l'intention de recherche de l'internaute. BERT a vocation à mieux comprendre cette intention de recherche au niveau du moteur, notre vocation reste d'y répondre de la meilleure des façons possibles, cela ne change finalement pas grand chose pour nous (en dehors des spammeurs, bien entendu...)…

Dans ce sens, il faut également voir que Google ne part pas d'une situation vierge. Cela fait des années qu'il travaille sur le contexte des recherches, la désambiguïsation, qu'il investit énormément dans le domaine du NLP (Natural Language Processing ou Traitement du Langage Naturel) et qu'il a déjà connu des avancées significatives à ce niveau. BERT est donc un nouveau pas dans ce sens, mais pas une rupture technologique forte.

On peut cependant se poser la question de savoir si BERT n'est appliqué qu'aux recherches (queries) des internautes et si cette nouvelle technologie ne pourrait pas également être utilisée dans la compréhension des textes identifiés sur le Web. Sur ce sujet également (mais on a l'habitude avec Google), la communication officielle semble légèrement ambigüe. Dans ce cas, BERT pourrait avoir un rôle à jouer dans la façon dont nous publions, en favorisant les contenus sémantisés (dans des phrases construites, de type "sujet-verbe-complément") plutôt que, par exemple, des listes à puces (bullet points) ou des tableaux (fiche technique ou autre). L'avenir nous en dira certainement plus à ce sujet. Restons en veille...

Sites de niche et recherches vocales : les grands bénéficiaires ?

D'une façon générale, BERT devrait avoir deux impacts majeurs pour le moteur :

- Privilégier les contenus de qualité, répondant de façon précise et pertinente aux intentions de recherche de l'utilisateur. Là encore, la notion d'EAT (en anglais : Expertise, Authoritativeness, Trustworthiness ou Expertise, Autorité, Confiance-Fiabilité) est centrale et encore plus au cœur des préoccupations du moteur ! Certains sites de niches ultra-pertinents sur des sujets très précis pourraient alors en tirer partie.

- Les requêtes vocales, souvent assez longues et proposant un contexte parfois plus complexe à appréhender que les mots clés "classiques", devraient pleinement profiter de ce nouvel algorithme. On peut même penser que BERT a été poussé dans ce sens, le vocal étant l'un des axes forts de R&D chez Google depuis des années.

Bref, répétons-le pour la 4 578ème fois 🙂 : travaillez pleinement l'intention de recherche de vos visiteurs et répondez-y en étant 2 fois meilleur que tout ce qui a déjà été publié à ce sujet sur le Web. Et BERT vous remerciera ! 🙂

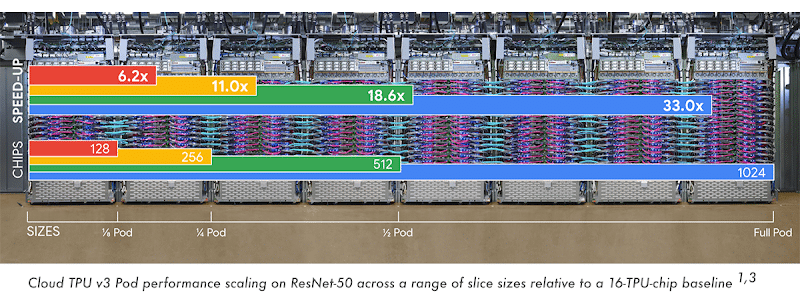

Source de l'image : Google

Participez à notre 1ère étude sur le netlinking & les relations presse

Participez à notre 1ère étude sur le netlinking & les relations presse

À gagner : 3 abonnements d’un an à Réacteur.com

À gagner : 3 abonnements d’un an à Réacteur.com

Quelques minutes suffisent. Un grand merci par avance à tous les participants !

Quelques minutes suffisent. Un grand merci par avance à tous les participants !